开云kaiyun.comFMLG基于自记忆语言模子-kaiyun全站体育app下载

封面新闻记者 欧阳宏宇开云kaiyun.com

近期,IEEE外洋蓄意机视觉与模式识别会议( Conference on Computer Vision and Pattern Recognition)CVPR 2025公布论文托福限度,其中一项来自中国的将AI应用于外接壤限平台案例筹谋论文《Teller: Real-Time Streaming Audio-Driven Portrait Animation with Autoregressive Motion Generation》(《基于自记忆看成生成的及时流式音频滥觞东谈主像动画系统》)被接收。

据先容,筹谋团队在论文中提议了一个新的面向及时音频滥觞东谈主像动画(即Talking Head)的自记忆框架,经管了视频画面生成耗时长的行业挑战外,还竣事了语言时头部生成以及东谈主体各部位通顺的当然性和传神性。

该论文的动机是解构diffusion-base的模子枢纽门径,用LLM和1step-diffusion进行重构,交融视频模态,使SoulX大模子成为同期生成翰墨、语音、视频的Unified Model。

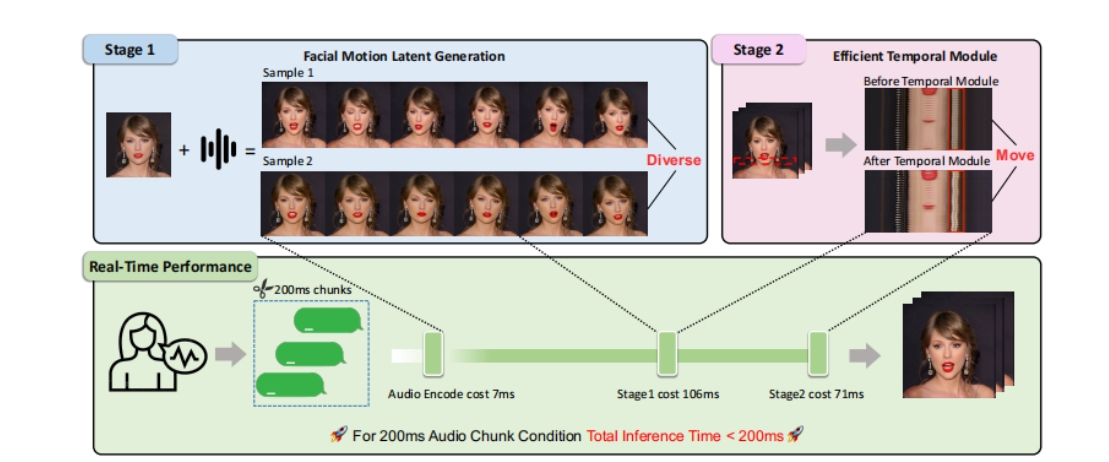

具体而言,来自Soul App的筹谋团队将talking head任务分红FMLG(面部Motion生成)、ETM(高效体魄Movement生成)模块。FMLG基于自记忆语言模子,诳骗大模子的强大学习才能和高效的各样性采样才能,生成准确且各样的面部Motion。ETM则诳骗一步扩散,生成传神的体魄肌肉、饰品的通顺效果。

实践限度标明,比拟扩散模子,该决策的视频生见效力大幅栽培,且从生成质料上来看,微细看成、面部体魄看成合营度、当然度方面均有优异证实。这解释了国产外接壤限互联网本事在鼓动多模态才能构建相称是视觉层面才能冲破上得到了阶段性后果。

谈及筹谋团队所矜恤的视觉交互逻辑,该平台CTO陶明解释称,从交互的信息复杂度来讲,东谈主和东谈主靠近面的一样是信息传播步地最快的,亦然最有用的一种。“是以咱们合计在线上东谈主机交互的经过当中,需要有这么的抒发步地。”

在他看来,在多模态大模子才能标的基础上,该决策的提议将有助于AI构建及时生成的“数字宇宙”,而况偶然以活泼的数字形象与用户进行当然的交互。

公开尊府败露,CVPR是东谈主工智能界限最具学术影响力的顶级会议之一开云kaiyun.com,是中国蓄意机学会(CCF)推选的A类外洋学术会议。在谷歌学术想法2024年列出的人人最有影响力的科学期刊/会议中,CVPR位列总榜第2,仅次于Nature。把柄会议官方统计,本次CVPR 2025会议总投稿13008篇,托福2878篇,托福率仅为22.1%。